2.2. 自然语言模型与发展历程:Transformer、BERT 与 GPT

自然语言模型可以理解为自然语言模型是人类所设计的一种机器人**,它可以做自然语言处理**,为了实现这个机器人,我们需要:- 设计一个算法,机器人拿到一堆文本之后,他应该在机器内部做哪些计算,计算出一个什么样的结果输出出来;

- 用足够多的数据训练它并告诉它正确答案,类比人类,当你学会了一类数学题的公式之后,你需要做足够多的正确的练习才能掌握;

自然语言发展简史

- 统计语言模型:以统计词频为主要手段的 n-gram模型,只能建立短程依赖,非常受到数据集的影响

- 2010 年,RNN(Recurrent Neural Network)

- 2013 年,word2vec:将每个词变成一个向量

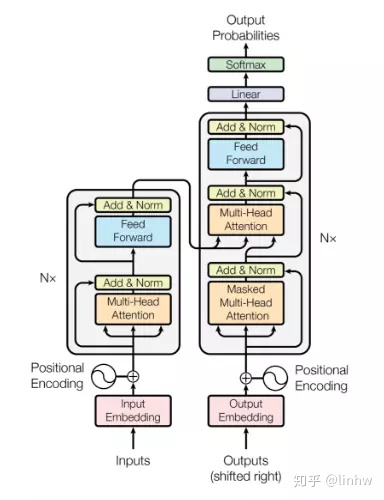

- 2017 年,Transformer:是当下 GPT 盛世的转折点,改变了以往序列建模和 RNN 划等号的思路,整个结构完全由注意力机制和前馈神经网络构成,架构如下:

- 2018 年,GPT:GPT 系列的起点,利用了 Transformer 的解码器部分作为特征提取,可以理解是让机器做文本续写

- 2018 年,BERT:利用了 Transformer 的编码器部分,对训练集进行双向训练,可以理解是让机器做完形填空

相关阅读: